בינה מלאכותית - יעילות, אפקטיביות וסכנה.

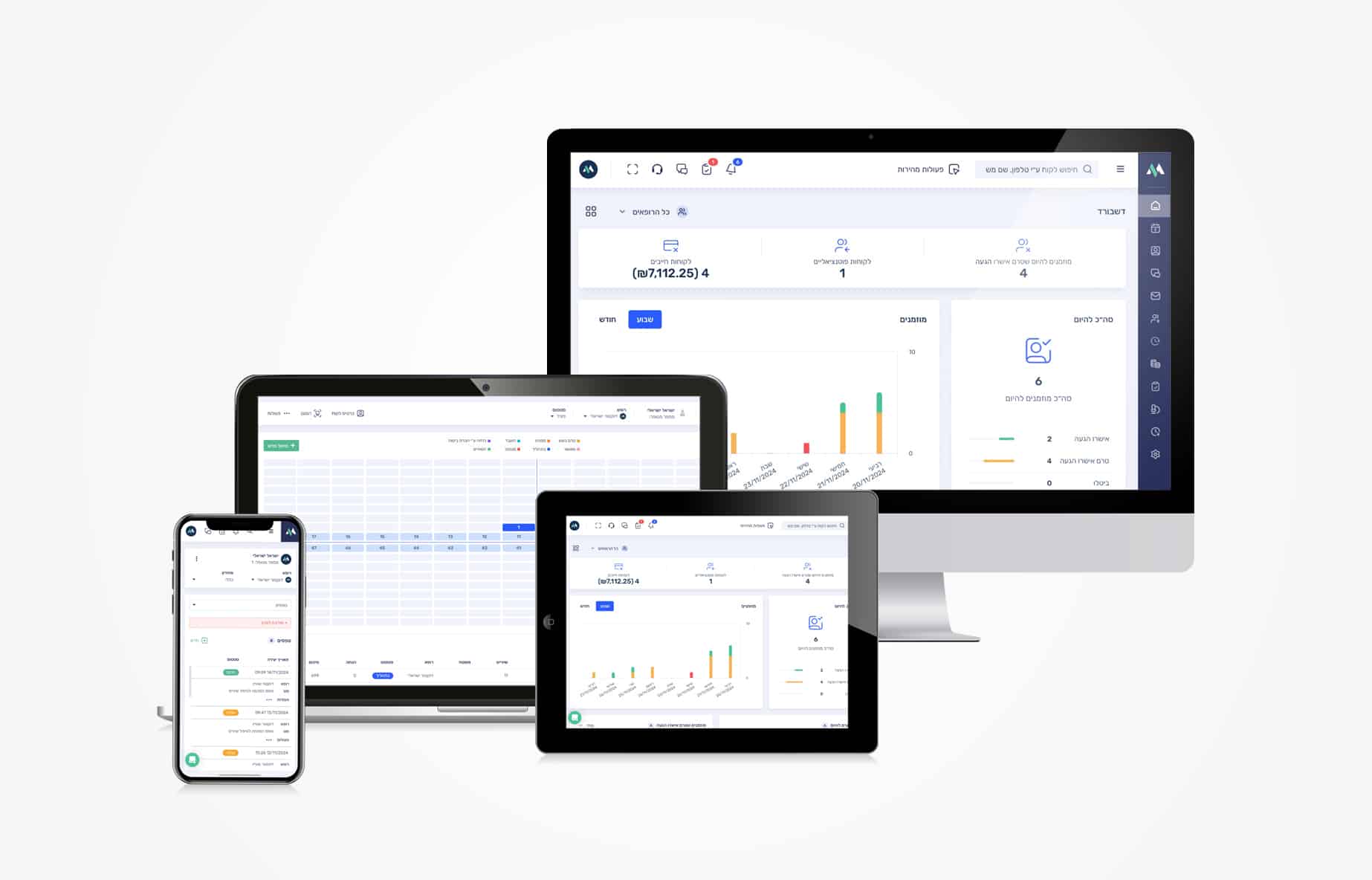

ראשית אציין שאני בעד בינה מלאכותית, כחברה אנחנו במדפורם מיישמים בינה מלאכותית היום במספר חזיתות, תקשורת עם מטופלים, קביעת תורים, סיכומי טיפול ועוד.

כבר במהלך הפיילוט עם רופאים/פרופסורים ומטפלים, הועלו נקודות מאוד מאוד חשובות, שבקלות, בחוסר זהירות, יכולות להפוך דבר כל כך יעיל כמו בינה מלאכותית לחרב פיפיות (נזק גם ללקוח)…

המטרה של המאמר הוא לשתף ולעודד, גם משתמשים וגם חברות אחרות בתחום, לקחת מקדם בטחון.

אפילו שהחוק בשלבים מוקדמים עדיין, ואינו אוכף בצורה "ראויה" את התחום…

"אוי זה נפלא"

בשלב הראשון שילבנו במדפורם סוכן שיודע לתקשר עם מטופלים, לקבוע תורים, לדרדר לצוות במקרה של חירום/בקשה, ולסכם טיפולים דרך כתב או מיקרופון.

"אוי זה נפלא" זו התגובה הראשונה של הרופא הראשון שהתרשם מהבינה המלאכותית במדפורם ביום הראשון של הפיילוט.

כמובן שזה מעלה חיוך בתור תוכנה לניהול מרפאות,

נכון, זה נפלא שיש סוכן שקובע תורים למטופלים ומתקשר איתם.

ועוד יותר נפלא שיש בינה מלאכותית ככלי סיכום שחוסך זמן יקר לרופא.

אבל באותו רגע שמח הבנו גם את גודל הסיכון.

דוגמא לסיכון בתקשורת של בינה מלאכותית עם מטופלים.

מי שלא עבד עם בינה מלאכותית (ולא, אני לא מדבר על בוט בצ'אט GPT או משהו בסגנון) אולי לא באמת מבין או מכיר את הנקודות המסוכנות.

לבינה מלאכותית יש מספר מדדים שונים, בין היתר

- הפרומפט – שאנחנו משתמשים בו, בעצם "הוראות הפעלה בסיסיות".

- טמפרטורה – לא מדובר במזג אוויר, מדובר בכמה "רנדומלי" או "לא קבוע" התשובות של הסוכן יהיו, תכף נרחיב.

- Guardrails – החלק שאחראי על חסימה של תוכן מסוכן כמו ניסיונות של חכמולוגים "לעקוף" את הוראות הפעלה, מוכר גם כ JAIL BREAK, יכול לגרום לסוכן לענות תשובות מסוכנות, ובעצם "לשנות" את ההוראות.

- הוראות בטיחות – מלמדים את הסוכן לזהות תוכן שעלול להיות מסוכן, רגיש, או עם רקע שלילי שלא נרצה שהמשתמשים יקבלו.

- "הזייה" – פשוטו כמשמעו, יצא לכם פעם להתקל בAI שאומר לכם דברים שלא קיימים בכלל?, זה קורה בגלל שהסוכן פשוט "הוזה" משהו שמעולם לא היה, או לא קיים, או שהוא מניח שקיים, ומספק מידע שגוי.

קיימים עוד מספר שיטות/מדדים ותכונות שלא נעמיק כאן, בין היתר , מדד חשיבה, אימון של הפרומפט ממידע ידני, מודל תגמול ועוד.

אז אולי כל זה לא מסוכן כששואלים את הסוכן איך להכין פיצה, או מבקשים ממנו לכתוב מאמר (לא קרה כאן..)

אבל כאשר בינה מלאכותית פוגשת תיעוד רפואי ותקשורת עם מטופלים לטעויות יש השלכות חמורות בהרבה.

נניח שמטופל שואל "כמה פעמים ביום אמרת לקחת את האנטיביוטיקה"?

הסוכן "חושב" "אוקיי המטופל צריך עזרה בתרופה שהרופא רשם לו" , "אני צריך להגיד לו כמה פעמים לקחת את התרופה", "אבל רגע, אני לא יודע איזו תרופה הוא קיבל" , "אני רואה לפי השיחה שהמטופל כתב שכואב לו הגרון והוא היה במרפאה" ,"נהוג לתת אנטיביוטיקה 3 פעמים ביום ל10 ימים לדלקת גרון" "אבל אולי לא כדאי שאמליץ משהו רפואי?, אני רואה שרשום לי בצורה מפורשת בהוראות לתת מענה למטופלים עבור המרפאה", "אוקיי קלי-קלות, אני אענה למטופל"

"היי מטופל, את האנטיביוטיקה לוקחים 3 פעמים ביום למשך 10 ימים, תרגיש טוב:) "

הבעיות בדוגמא הזו, היא לא רק מה שאתם חושבים…

הבעיה שהמטופל מעולם לא קיבל אנטיביוטיקה, כמו שאתם עכשיו "לקחתם" את זה כמובן מאליו, גם הסוכן, "מניח" שאם המטופל רשם את זה אז זה נכון.

הבעיה השנייה שהוא "הניח" שזו דלקת גרון, אבל זה בכלל היה ויראלי, ולרוב לא נותנים אנטיביוטיקה לויראלי.

הבעיה השלישית שהסוכן אמר לו כמה פעמים לקחת ביום את התרופה.

כשמשלבים סוכן בינה מלאכותית ברפואה, צריך הרבה אחריות, מקצועיות, ויכולות חשיבה של עשרות צעדים קדימה, כי כל מה שיכול לקרות יקרה.

הסיכון בתיעוד רפואי בעזרת בינה מלאכותית

זה מסוכן שבינה מלאכותית עונה למטופל עם הוראות שגויות, אבל זה עוד יותר מסוכן כשזה מגיע לתיעוד רפואי.

ראשית, יש להבין שבינה מלאכותית היא "כלי עזר" בלבד.

אם הרופא הממוצע כותב 1000 מילים ביום, אז הבינה יכולה לעזור לו לכתוב דברים בנאליים, שהוא בד"כ כותב, ולקצר לו את התהליך.

אבל האחריות של הרופא היא לוודא את מה שהבינה מלאכותית סיכמה לפי ההוראות שלו.

אז אפילו שיש כסת"ח חוקי לנושא, הסיכון עדיין קיים.

כשרופא מסכם הליך, הוא מציין את הדברים החשובים שנעשו, ממצאים היסטוריה, צ'ארטינג מדוייק ועוד המון דברים לפי התחומים השונים.

בהקשר הזה, כפי שציינו קודם, בינה מלאכותית עלולה "להזות" דברים שלא היו, לזהם את התיעוד הרפואי ואפילו לסכן חיים.

נניח שרופא סיכם ניתוח, אך "שכח" לרשום את התרופה שנתן למטופל.

במצב של "הזייה" הסוכן עלול להזות שהרופא רשם אנטיביוטיקה ספציפית כנהוג בניתוחים דומים, או שהרופא "לא שם לב" שהבינה המלאכותית החליטה שלמטופל היה דימום מאיזשהו איבר בזמן הניתוח רק בגלל שהרופא רשם "דימום".

מי שעובד בתחום לא צריך הסבר על כמה מסוכן זה שתיעוד רפואי שגוי, לא אזכיר בכלל את ההשלכות החוקיות…

לכן , לפני שאתם סומכים על "אחיין" שלכם, או מישהו שסיים קורס ביוטיוב שיסדר לכם נציג AI במחיר טוב דרך CHATGPT או אחרים, תחשבו טוב לפני, בינה מלאכותית בידיים לא מקצועיות עלולה להיות אסון.

אז איך כן מנצלים לטובה את הבינה המלאכותית?

לבינה מלאכותית יש כל כך הרבה להציע,

אבל חשוב לנהוג באחריות.

חשוב לאמן את הבינה באופן יומיומי.

להגביל את המדדים כדי למנוע מצבי "הזייה", להשתמש בגרסאות המתקדמות (וכן.. היקרות) ביותר.

לבדוק אלפי פרומפטים שונים ולהריץ סיטואציות שונות ולקבל מידע מ"BIG DATA", בעצם מצב בו אנחנו עושים סימולציות שונות של שיחות מול הסוכן כדי לראות מה קורה בתשובה מספר 1000 לצורך העניין.

להריץ סוכן נוסף במקביל, שכל תכליתו זה לבדוק את הסוכן הראשון. (תמיד מומלץ בהתחלה כדי למנוע מצבים מסוכנים)

והכי חשוב, לשתף את הלקוחות בשקיפות מלאה, להסביר להם שהבינה המלאכותית היא כלי עזר בלבד לנהל את המרפאה, ולא טייס אוטומטי.

גם שלקוחות ציינו בפנינו שהם בודקים ומוודאים את התקינות, אנחנו מריצים סוכנים נוספים שתפקידם לבדוק את הסוכן הראשון.

גם אם הבעיה לא צצה 9999 פעמים, היא עלולה לצוץ בפעם ה10,000 לכן עלינו לעשות הכול כדי לשמור על לקוחותינו הרופאים, ובמיוחד על המטופלים. (כן. גם אם יש כסת"ח)

מאמרים נוספים

איך לבחור תוכנה לניהול מרפאה ב2026

איזה חידושים יש בתוכנות לניהול מרפאה בשנת 2026? מה כדאי לשקול לפני שבוחרים תוכנה? ואיך אפשר להבטיח שהמערכת תתאים לצרכים של הקליניקה/מרפאה שלכם.

תוכנה לניהול מרפאה – ענן נגד מקומי

צריך לשקול מספר דברים חשובים לפני שבוחרים תוכנה, יש גורמים כמו אבטחה, פרטיות, מהירות, וחוקיות שצריך לבחון, מאמר זה נועד לשפוך אור בנושא.